| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

- sLLM

- djangorestframework

- conda

- 티스토리챌린지

- ai 캠프

- 파이썬

- EC2

- 오블완

- Python

- django

- aws

- chromeextention

- seaborn

- Jupyterlab

- team_project

- 로컬 런타임

- mysql

- pytorch

- streamlit

- ollama

- ML

- mifare

- Github

- 정치기 필기

- ai_캠프

- ai캠프

- lightsail

- 머신러닝

- pandas

- finpilot

- Today

- Total

greatsangho의 이야기

Continue - 무료로 코딩 자동 완성 툴 사용 및 모델 별 간단 성능 비교 본문

설명 : Continue 코딩 어시스턴트는 개발자가 코드 작성 및 유지보수 업무를 보다 쉽고 효율적으로 수행할 수 있도록 돕는 오픈 소스 AI 기반 도구입니다. 이 도구는 VS Code와 JetBrains와 같은 인기 있는 통합 개발 환경(IDE)에 플러그인 형태로 통합되어, 코드 자동 완성, 리팩토링, 코드베이스에 대한 질문 및 문서화 활용 등 다양한 기능을 제공합니다.

Continue

Amplified developers, AI-enhanced development · The leading open-source AI code assistant. You can connect any models and any context to build custom autocomplete and chat experiences inside the IDE

www.continue.dev

Ollama

Get up and running with large language models.

ollama.com

Ollama 설치 및 무료 사용 가이드

Ollama는 로컬 환경에서 대형 언어 모델(LLM)을 실행할 수 있도록 돕는 오픈소스 도구입니다. 인터넷 연결 없이도 AI 모델을 실행할 수 있으며, 다양한 운영체제에서 사용할 수 있습니다. 아래는 Ollama를 설치하고 사용하는 방법을 단계별로 정리한 가이드입니다.

1. Ollama란?

Ollama는 로컬에서 LLM을 실행할 수 있는 도구로, Meta의 Llama2, Mistral, CodeLlama 등 다양한 모델을 지원합니다. 주요 특징은 다음과 같습니다:

- 무료 오픈소스: 비용 부담 없이 사용할 수 있음.

- 로컬 실행: 클라우드 의존 없이 PC에서 AI 모델 실행 가능.

- 다양한 모델 지원: 범용 모델부터 코드 생성 특화 모델까지 제공.

- 사용자 정의 가능: 프롬프트와 설정을 통해 모델 커스터마이징 가능.

모델 다운로드

- 터미널(또는 cmd)에서 아래 명령어로 모델을 다운로드합니다:예시: llama3는 범용 LLM이며, 필요에 따라 다른 모델도 선택 가능합니다(예: codellama).

ollama pull llama3모델 실행

- 다운로드한 모델을 실행하려면 다음 명령어를 사용하세요:

- 실행 후 프롬프트가 나타나면 질문이나 명령어를 입력하여 AI와 상호작용할 수 있습니다.

ollama run llama3- 모델 목록 확인: 사용 가능한 모든 모델은 아래 명령어로 확인 가능합니다:

ollama list- 모델 삭제: 더 이상 필요하지 않은 모델은 다음 명령어로 삭제할 수 있습니다:

ollama rm <모델 이름>Ollama의 장점

- 무료 사용 가능: 상업적 용도로도 무료로 사용할 수 있는 라이선스를 제공합니다.

- 클라우드 의존 없음: 로컬 환경에서 모든 작업이 이루어져 데이터 보안 우려가 적습니다.

- 다양한 플랫폼 지원: Windows, macOS, Linux 모두에서 사용 가능.

사용해보니 GTX1070ti 기준

이정도 모델이 사용하기 적합하게 느껴졌다.

대략 5GB 전후의 크기일 때 거의 지연없이 작동하였다.

deepseek의 경우 다른 모델들과 달리 내부적으로 추론과정을 거친 뒤 답변을 생성하는 차이가 있었다.

코딩을 할 때 영어를 사용해서 코드를 유지보수 한다는 가정하에 Github copilot, Amazon Q, Cursor AI의 월 무료사용 한도에 이르렀을 때 좋은 대안이 될 것이라는 생각이 든다.

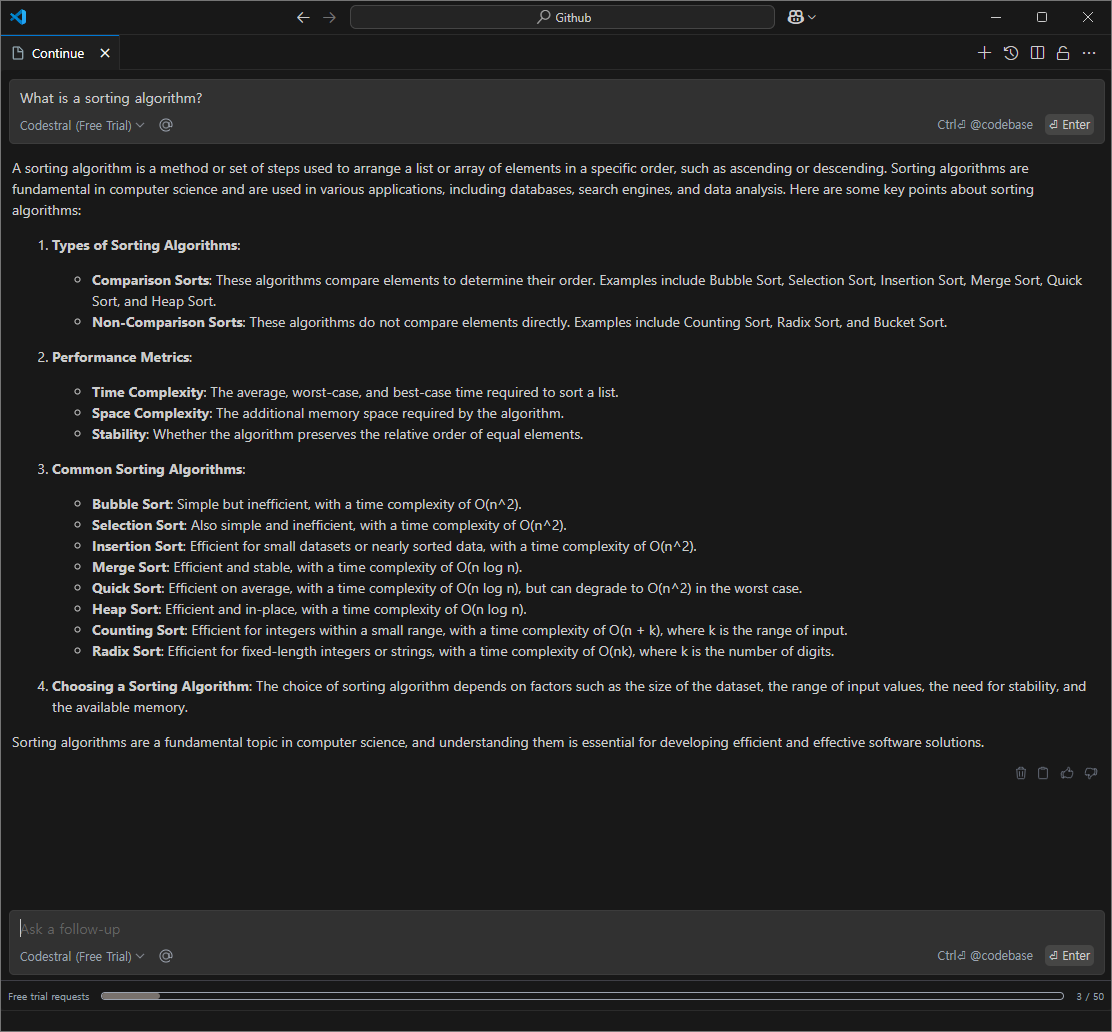

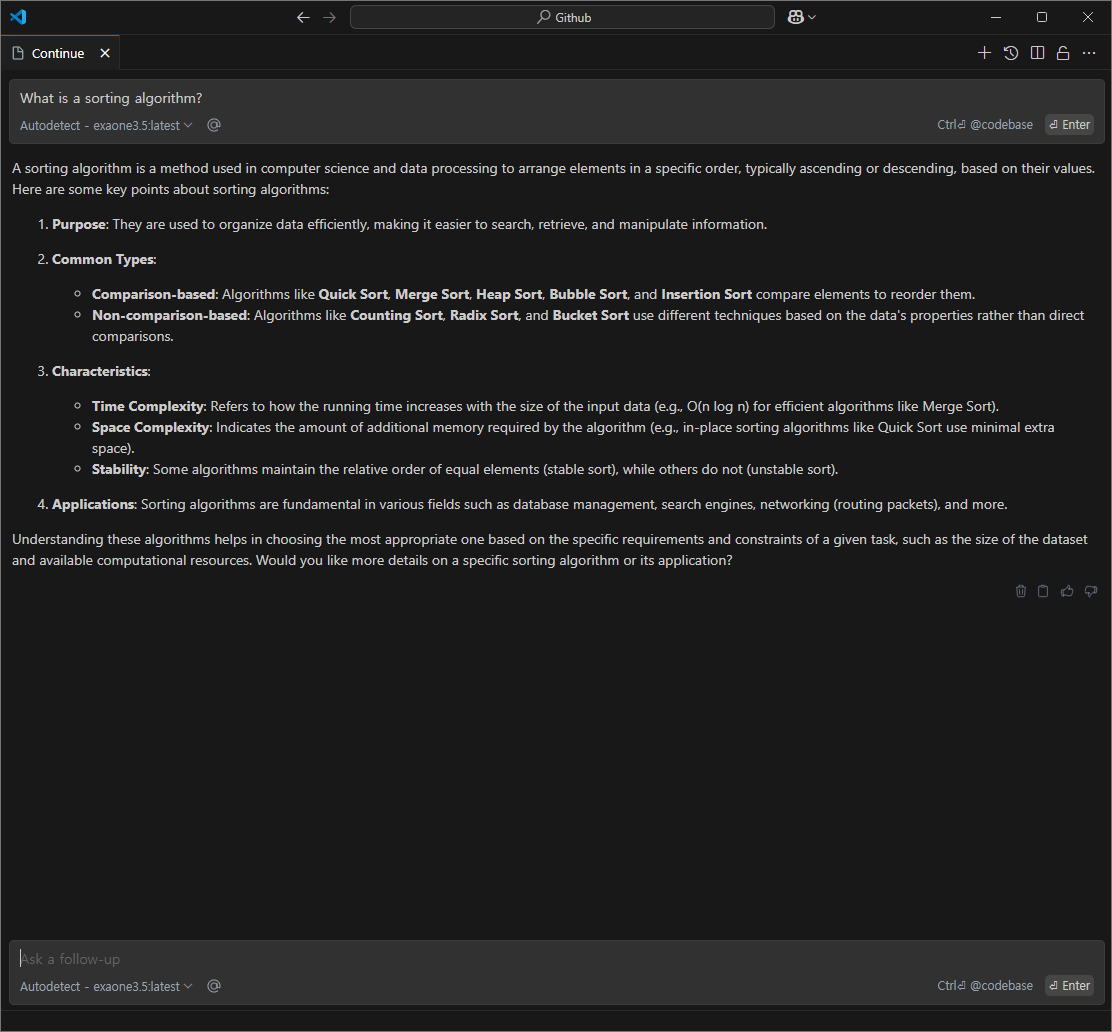

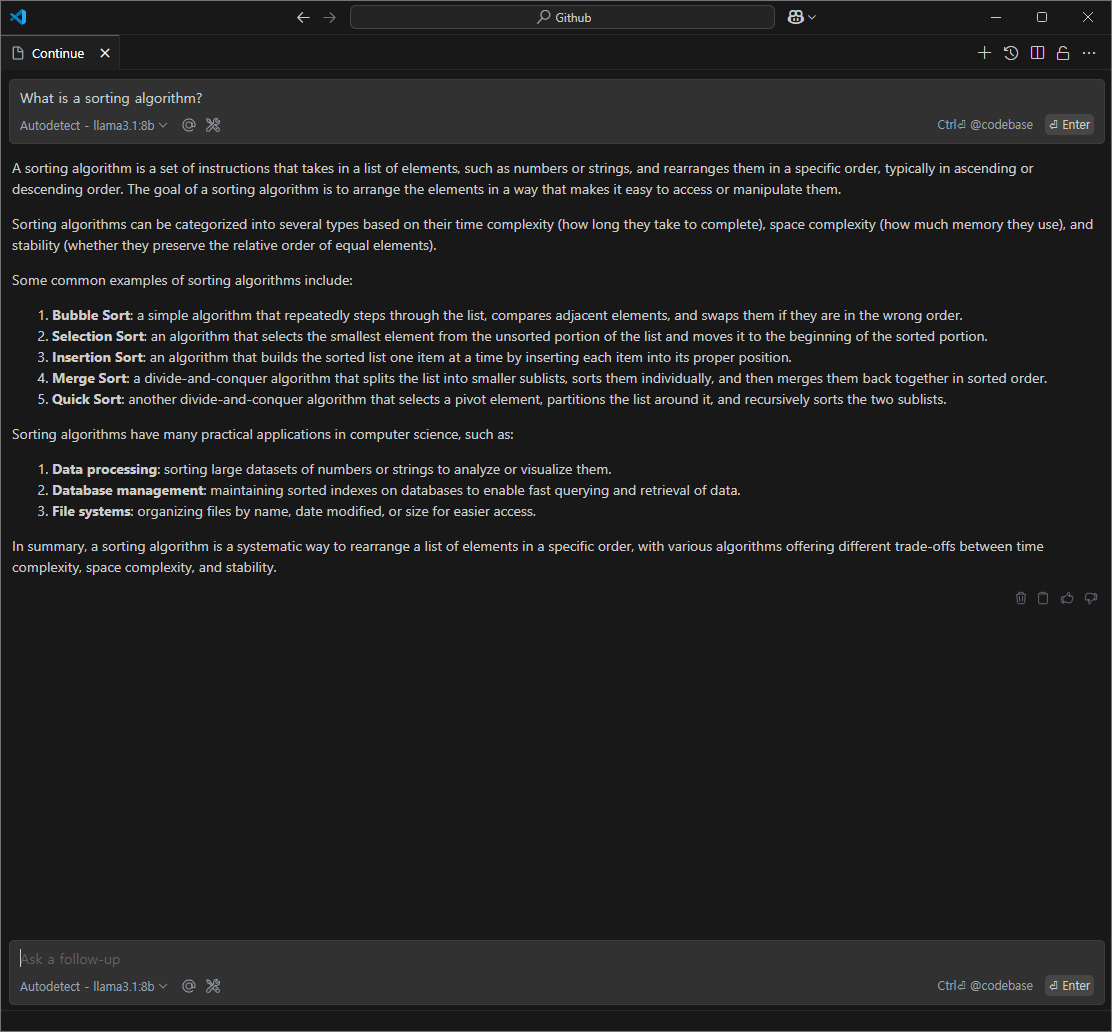

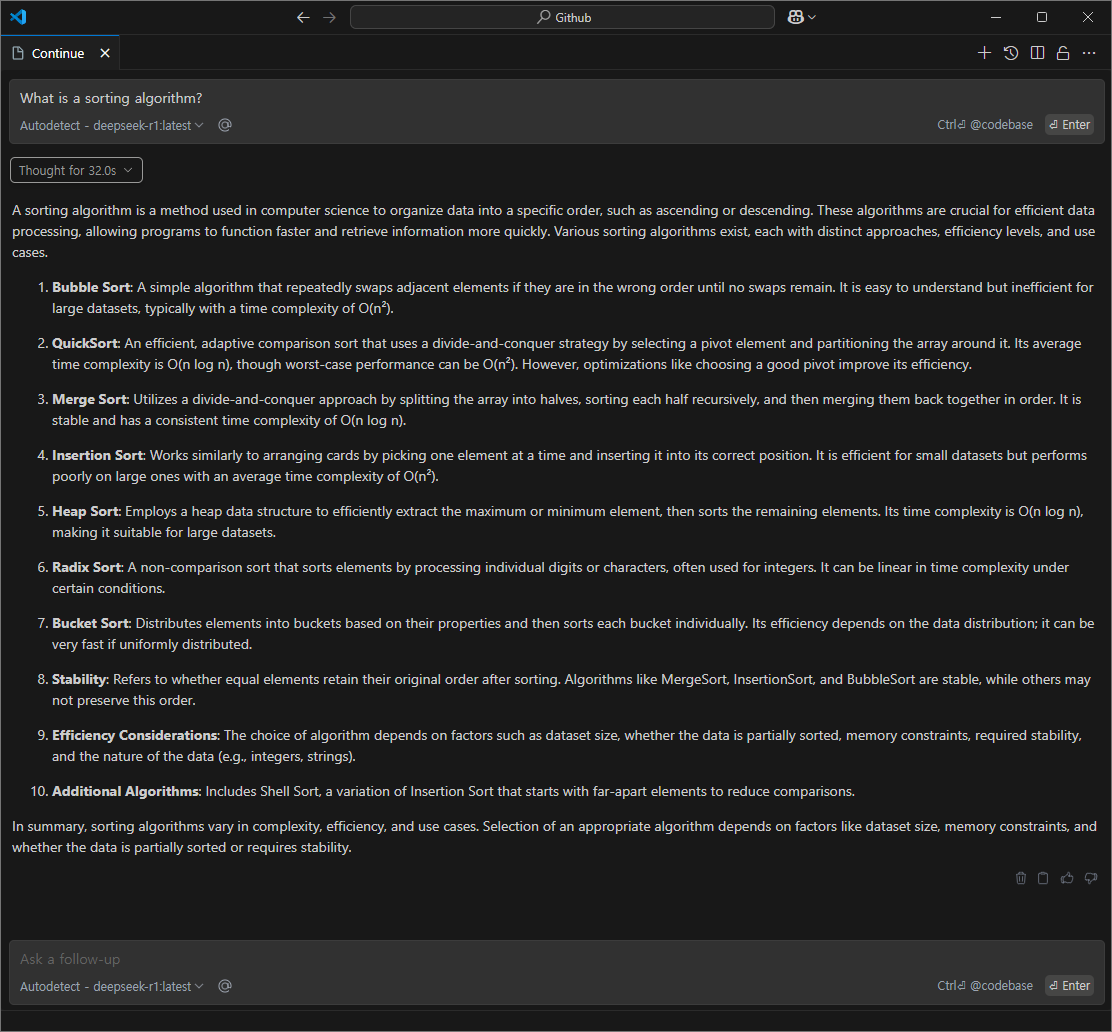

What is sorting algorithm? 질문에 대해 각 모델을 비교해보면,

전체적으로 사용해 보았을 때 길이를 기준으로 보면 deepseek와 Claude 3.5 Sonnet이 길다는 것을 알 수 있다. 특히 놀라운 점은 딥시크가 로컬환경(오프라인) 인 상황임에도 api를 사용하는 경우보다 자세한 답변을 해주는 것을 알 수 있다.

딥시크는 내부적으로 바로 답변을 못하고 스스로 질문을 하는 프로세스로 빠지기도 하는데 같은 질문을 해도 바로 나오는 경우가 있고, 고민하다 답변을 하는 경우가 있다. 기존에 사용할 때는 7b는 스스로 생각하는 과정이 잘 없었는데 이번 테스트에서 추론을 하여 30초 정도 시간이 소요됨을 확인할 수 있었다.

코드를 수정해주는 모델로는 qwen2.5-coder:1.5b가 추천되는데, 사용해보니 qwen2.5-coder:3b도 시간이 비슷하며 성능이 더 높은 3b모델로 설정하여 사용하는 것이 좋을 것 같다. 다른 모델을 사용해봤지만 qwen2.5-coder:3b가 가장 성능이 좋게 느껴졌다.

phi4는 14b인 만큼 출력 결과가 가장 정리가 잘 되었다고 느꼈다. 컴퓨터의 성능이 충분하다면 사용할 것 같다는 생각이 들었다.

ollama에서 llm 모델을 사용하고자 할 때 참고하면 좋을 것이다.